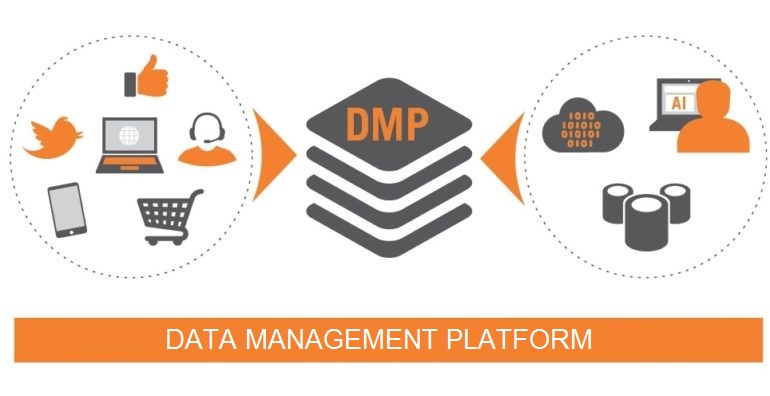

Nếu các bạn hoạt động, làm việc trong lĩnh vực thương mại điện tử (E-commerce) hay digital marketing chắc biết đến Data management platform (DMP) còn được gọi là nền tảng quản lý dữ liệu tập trung. Thông qua DMP, các công ty có thể thu thập dữ liệu khách hàng, người dùng từ nhiều nguồn khác nhau và tập trung vào một chỗ, mục đích để quản lý, lưu trữ, tiến hàng phân tích, kết quả thu được sẽ hỗ trợ hiệu quả các chiến dịch tiếp thị truyền thông kỹ thuật số, quảng cáo, chiến dịch bán hàng,…ví dụ điển hình như xây dựng hệ thống khuyến nghị (giới thiệu sản phẩm đúng với nhu cầu, sự quan tâm của khách hàng).

Các chức năng chính của DMP gần tương đồng với các bước trong một quy trình lớn hơn là Data management – quản lý dữ liệu. BigDataUni giới thiệu DMP ở đầu bài viết để bắt cầu nói về Data management, một thuật ngữ rộng hơn, phạm vi bao quát hơn, áp dụng cho mọi loại dữ liệu, mọi ngành và lĩnh vực. Khối lượng dữ liệu mà mỗi tổ chức phải thu thập ngày nay là rất lớn, không chỉ riêng dữ liệu khách hàng, do đó sẽ xuất hiện nhiều vấn đề, và thách thức phải đối mặt.

Data management theo các chuyên gia mặc dù đã xuất hiện từ lâu nhưng trong những năm lại dành được nhiều sự quan tâm khi nhu cầu khai thác dữ liệu hiệu quả ngày càng cao. Data management đóng vai trò quyết định cho sự thành bại của bất kỳ dự án Big data, Data mining, Data analytics hoặc thậm chí là AI, Machine Learning, nói chung là liên quan đến tất cả các hoạt động cần khai thác dữ liệu.

BigDataUni sẽ gửi đến các bạn các bài viết với chủ đề về quản lý dữ liệu bắt đầu với Data management, tiếp theo là Data quality management, – một thành phần quan trọng của Data management hoặc có thể tách biệt với Data management nhưng dễ khiến chúng ta nhầm lẫn.

Phần 1 bài viết “Tầm quan trọng của Data management”, chúng tôi sẽ giới thiệu đến các bạn khái niệm, định nghĩa chính xác về quản lý dữ liệu, các thành phần, và quy trình chính có trong Data management. Khi thành tựu của công nghệ kỹ thuật của thời đại 4.0 (là Big data, AI, Machine Learning) đang trở thành xu hướng toàn cầu, thì dữ liệu đã trở thành tài sản vô giá của mỗi công ty bên cạnh nhân lực và tài chính.

Dữ liệu gồm nhiều loại và từ nhiều nguồn khác nhau ví dụ từ hệ thống giao dịch, các “điểm tiếp xúc” với khách hàng, hệ thống sản xuất, máy quét, hệ thống cảm biến, từ các website, kênh bán hàng trực tuyến, social media, các ứng dụng thông minh xây dựng cho khách hàng,… Như đã nói, không chỉ đa dạng về loại và nguồn thu thập, dữ liệu ngày nay còn mang lại thách thức về độ lớn khối lượng. Nhưng quan trọng hơn cả là chúng ta phải xác định được “Dữ liệu ẩn chứa thông tin hữu ích gì?” “Dữ liệu có giá trị phân tích không?”, “Cái gì quyết định giá trị của dữ liệu?”, “Làm cách nào để khai phá tri thức từ dữ liệu?”, “Dữ liệu thu thập có liên quan đến mục tiêu kinh doanh?”, “Tiếp cận, thu thập, làm sạch, tích hợp, lưu trữ dữ liệu như thế nào để tiến hành phân tích?”.

Để trả lời cho các câu hỏi trên thì bước đầu tiên quan trọng nhất phải thực hiện đó chính là Data management.

Data managementlà gì?

Hiểu đơn giản nhất: “Data management best practices = better Data analytics” nghĩa là nếu chúng ta quản lý dữ liệu hiệu quả thì việc phân tích sẽ diễn ra tốt hơn, kết quả chính xác hơn. Data management có thể được xem là các bước ban đầu chuẩn bị dữ liệu để phân tích hay các bước xử lý kết quả (xử lý dữ liệu) sau giai đoạn phân tích. Nhiều công ty thường thất bại trong các dự án Big data, Data mining, hay Data analytics mà nguyên nhân xuất phát từ khâu quản lý dữ liệu không hợp lý. Điển hình như dữ liệu không trong trạng thái “sẵn sàng”, chưa được hoàn chỉnh lại bị đem vào phân tích một cách vội vã, ví dụ dữ liệu không được chọn lọc, không được làm sạch, không được chuyển đổi đúng cách; dữ liệu bị trùng lặp, định dạng dữ liệu mới, không tương thích với phần mềm phân tích,..

Data management là việc xây dựng, tổ chức, bảo trì, kiểm soát các hệ thống, quá trình (được tích hợp trong những mô hình kinh doanh hiện đại) xử lý dữ liệu như thu thập, lưu trữ, chọn lọc, làm sạch, chuyển đổi, phân tích,… hay kiểm soát các hoạt động có trong vòng đời dữ liệu (hoặc vòng đời thông tin) từ xác định mục tiêu kinh doanh đến trực quan hóa dữ liệu, áp dụng kết quả phân tích vào thực tế.

Nói cách khác, Data management là một tập hợp đầy đủ các công việc thực tiễn, các quy trình, các “concept” kết hợp với một loạt các hệ thống, công cụ cho phép tổ chức “giành quyền kiểm soát” và quản lý nguồn tài nguyên dữ liệu của mình. Data management xuất hiện trong mỗi giai đoạn của vòng đời dữ liệu ví dụ xem xét trong một tập dữ liệu, Data management tác động từ điểm bắt đầu của việc thu thập, hình thành tập dữ liệu cho đến điểm kết thúc lưu trữ hay loại bỏ tập dữ liệu sau khi đã phân tích.

Theo The Global Data Management Community, còn được gọi là DAMA, trích dẫn trong The Data Management Body of Knowledge (DMBOK) – tài liệu hướng dẫn về Data management thì định nghĩa Data management như sau:“The development, execution, and supervision of plans, policies, programs, and practices that deliver, control, protect, and enhance the value of data and information assets throughout their lifecycles.”(phiên bản 1 của tài liệu không có “throughout their lifecycles”, định nghĩa trên của phiên bản 2).

Nghĩa là, Data management là việc phát triển, triển khai, giám soát các kế hoạch, chính sách, chương trình hoạt động, và các công việc thực tiễn nhằm cung cấp (phân phối), kiểm soát, bảo vệ, gia tăng giá trị của tài sản dữ liệu và thông tin xuyên suốt vòng đời của chúng.

Yêu cầu về quản lý dữ liệu hiệu quả đã trở nên cấp bách và cấp thiết hơn đặc biệt đối với các tổ chức lớn khi họ phải tuân thủ các quy tắc, luật lệ về bảo mật dữ liệu người dùng, bảo mật thông tin cá nhân,… ví dụ như điều luật GDPR (General Data Protection Regulation) bộ luật bảo vệ dữ liệu chung được ban hành và áp dụng tại các nước trong liên minh châu Âu (EU) từ tháng 5/2018, và Luật An ninh mạng chính thức có hiệu lực tại nước ta trong năm 2019.

Ngoài ra, ngày nay nhiều công ty sản xuất, dịch vụ quy mô từ nhỏ đến lớn triển khai các hoạt động kinh doanh trực tuyến thông qua Internet, ví dụ sử dụng các kênh khác nhau để bán hàng như website, social media,… áp dụng các hình thức giao dịch, thanh toán online, hỗ trợ tư vấn khách hàng qua các ứng dụng, nền tảng nhắn tin như Zalo, Facebook Messenger, triển khai các chiến dịch tiếp thị kỹ thuật số (digital marketing) trên Facebook, Google,… Mỗi hoạt động đều cung cấp một khối lượng dữ liệu đa dạng và hữu ích cần được quản lý hiệu quả để phục vụ việc phân tích.

Một chút về lịch sử Data management

Mặc dù Data management là công cụ quan trọng và phổ biến hiện nay nhưng đã xuất hiện từ rất lâu. Theo TechTarget, và Dataversity, thuật ngữ Data management đã xuất hiện từ những năm 1960 khi tổ chức ADAPSO (the Association of Data Processing Service Organizations) – hiệp hôi các tổ chức cung cấp dịch vụ xử lý dữ liệu – đưa ra dịch vụ tư vấn, chương trình tập huấn, đào tạo quản lý chất lượng, quản lý dữ liệu. Vấn đề về quản lý dữ liệu đã được quan tâm đặc biệt từ những năm 1950 do hệ thống máy tính lúc đó rất chậm, cồng kềnh, chức năng còn kém không thể lưu trữ, xử lý dữ liệu, hơn nữa cần sử dụng một lực lượng nhân công lớn để vận hành.

Mặt khác các công ty lại dành mọi không gian để chứa tất cả thẻ bấm lỗ gọi là “punch cards” để lưu trữ thông tin, dữ liệu kỹ thuật số. Chính vì vậy, các giải pháp hỗ trợ quản lý dữ liệu trong giai đoạn này là vô cùng cần thiết. Đây cũng có thể được xem là điểm khởi đầu đánh dấu sự ra đời và phát triển sau này của Data management.

Hình ảnh ví dụ về Punch card

Tiếp theo BigDataUni sẽ giới thiệu đến các bạn phần quan trọng tiếp theo chính là các quy trình, hay cũng có thể gọi là các thành phần/ chức năng có trong Data management.

Thật ra có rất nhiều cách phân loại, chọn lựa các công việc, và thành phần có trong Data management, tùy vào quy mô, khả năng, nguồn lực, mục tiêu trong kinh doanh, tính chất nguồn dữ liệu,.. mà các tổ chức có thể quyết định xây dựng một hệ thống Data management hoàn chỉnh, đầy đủ hay chỉ bao gồm các chức năng chính mà thôi.

Mặc dù vậy theo SAS – công ty đi đầu về lĩnh vực phân tích dữ liệu trụ sở tại Hoa Kỳ, và các chi nhánh trên toàn cầu, cung cấp dịch vụ tư vấn về dữ liệu, phần mềm phân tích dữ liệu cao cấp – cho rằng một hệ thống Data management cần phải có đủ những chức năng, thành phần sau:

- Data access

Dữ liệu mới trở thành tài sản của một tổ chức khi và chỉ khi tổ chức ấy có thể lấy được dữ liệu theo yêu cầu, mục tiêu đề ra. Data access – tiếp cận dữ liệu – liên quan đến khả năng tiếp cận, thu thập thông tin từ, dữ liệu từ bất kỳ nguồn nào. Dữ liệu mà mỗi tổ chức, công ty phải thu thập có thể đến từ nhiều nơi khác nhau như các bảng tính Excel, các tệp văn bản, từ các cơ sở dữ liệu, từ các email, các ứng dụng kinh doanh, bán hàng thông minh, từ các website, các trang mạng xã hội, và dữ liệu truyền về từ các thiết bị I.o.T (Internet of things – Internet vạn vật). Do đó nếu không có một biện pháp hiệu quả trong Data access, thì quá trình thu thập sẽ rất khó khăn ảnh hưởng đến toàn bộ hệ thống Data management. Chưa xét đến việc một tổ chức đã xây dựng một chiến lược cụ thể cho Data management, nhưng việc đầu tiên cần quan tâm sau khi đã xác định các mục tiêu kinh doanh, đó chính là xác định dữ liệu, nguồn dữ liệu hợp lý và cách thức tiếp cận và thu thập sao cho hiệu quả. Các công cụ, phần mềm tiên tiến được sử dụng, kế hoạch chi tiết được đề ra trong Data access sẽ hỗ trợ tổ chức thu thập, trích xuất dữ liệu tốt hơn.

- Data integration

Data integration hay còn gọi là tổng hợp, tích hợp dữ liệu. Dữ liệu mà mỗi tổ chức, công ty phải thu thập đến từ nhiều nguồn khác, không đồng nhất, và có nhiều định dạng khác nhau. Sau khi thu thập dữ liệu từ các nguồn khác nhau thì thông thường mỗi công ty, tổ chức phải tiến hành tích hợp tất cả dữ liệu khác nhau, cụ thể là kết hợp các dữ liệu khác nhau vào chung một cấu trúc, format, tính chất nhất định,…(hoặc chuyển đổi dữ liệu này về cùng với dữ liệu kia để tổng hợp vào những tập dữ liệu thống nhất). Nói cách khác, Data integration mục tiêu là lưu trữ dữ liệu từ nhiều nguồn khác nhau trong một hệ cơ sở dữ liệu, một nguồn dữ liệu nhất định, dưới dạng các bảng tính, tệp dữ liệu,..để hỗ trợ quản lý và phân tích trong tương lai. Mặc dù quá trình tích hợp có thể gặp khó khăn, nhưng lợi ích nó đem lại, không chỉ quyết định đến tính hiệu quả của hệ thống Data management, mà còn cung cấp những thông tin hữu ích trong lúc tích hợp. Ví dụ công ty có một tập dữ liệu về thông tin cá nhân khách hàng như số điện thoại, nghề nghiệp, tuổi,.. và một tập dữ liệu về số lần giao dịch khách hàng, sản phẩm giao dịch, mức giao dịch, lần cuối giao dịch,…Kết hợp 2 tập dữ liệu công ty có thể xác định được những phân khúc khách hàng “thú vị”, “đâu là nhóm khách hàng tiềm năng nhất”, “đâu là sản phẩm được quan tâm theo nhóm tuổi/ thu nhập/…?”. Để giúp các công ty giảm bớt các thách thức Data integration, nhiều tập đoàn công nghệ IBM, Microsoft hay các tổ chức đi đầu lĩnh vực phần mềm phân tích, giải pháp dữ liệu như Oracle, SAS đã cho ra mắt nhiều công cụ hỗ trợ Data integration tốt hơn.

- Data quality

(nguồn hình isoqarindia.com)

Data quality liên quan đến các công việc xem xét và đảm bảo dữ liệu thu thập là chính xác, phù hợp, có thể được dùng cho các mục đích phân tích sau này. Theo SAS, cũng giống như quy chuẩn chất lượng ISO trong sản xuất, thì các công ty cần triển khai kiểm soát Data quality tại bất cứ giai đoạn có trong Data management. Điều quan tâm sau cùng khi chúng ta triển khai bất kỳ dự án về dữ liệu nào đó chính là giá trị của dữ liệu, thông tin hữu ích chúng ta có sau khi phân tích dữ liệu. Tất cả đều bị ảnh hưởng bởi chất lượng dữ liệu hay gọi là Data quality. Giả sử nếu không tiến hành kiểm tra chất lượng dữ liệu trong Data access, trong bước đầu tiên là thu thập dữ liệu, thì các quá trình, chức năng còn lại trong Data management sẽ gặp thất bại, dẫn đến kết quả phân tích cuối cùng không còn giá trị. Tuy nhiên không chỉ phải tiến hành thực hiện Data quality tại Data access mà còn song song ở tất cả các chức năng khác, xuyên suốt toàn bộ hệ thống Data management từ điểm bắt đầu thu thập dữ liệu, tích hợp dữ liệu đến điểm kết thúc là trước khi bàn luận về kết quả phân tích (trước khi xuất các báo cáo trực quan hóa, các đồ thị, bảng biểu cần kiểm tra lại dữ liệu và kết quả).

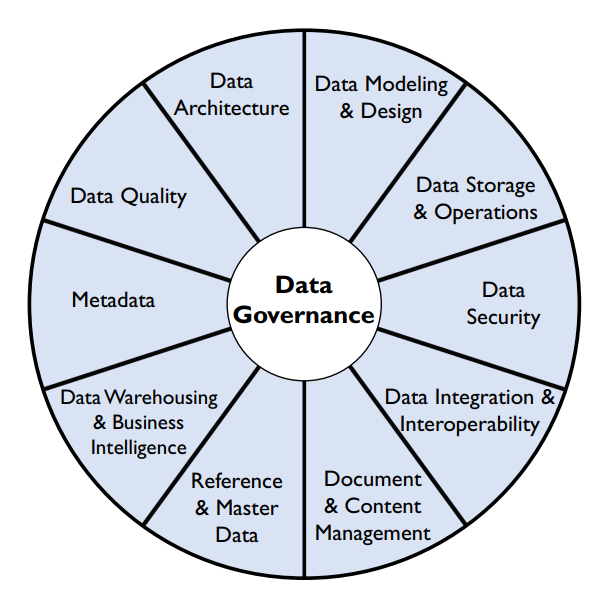

- Data governance

Data governance – quản trị dữ liệu – là chức năng cốt lõi của hệ thống Data management. Nhiều người thường nhầm lẫn giữa Data governance và Data management, nhưng thực chất không phải, như các bạn thấy trong bài viết này, ở đây Data governance là một phần, một chức năng của Data management mà thôi. Ở bài viết sắp tới BigDataUni sẽ giới thiệu về Data governance nhiều hơn, vì Data governance cũng đóng vai trò quan trọng trong việc hỗ trợ khai thác dữ liệu hiệu quả. Data governance là một bộ các quy tắc, chính sách, quy trình, chiến lược, bao gồm các quyết định về nhân lực và công nghệ áp dụng. Data governance là “kim chỉ nam”, định hình cách thức mỗi công ty quản lý, bảo vệ dữ liệu của họ như thế nào, đảm bảo các mục tiêu khai thác, quản lý dữ liệu luôn đi đôi với các mục tiêu kinh doanh. Nói cách khác, Data governance là việc lập kế hoạch, thực thi, giám sát tất cả các hoạt động quản lý dữ liệu, tức là tất cả các quy trình, chức năng có trong Data management được kể ở trên và sắp tới đây được kiểm soát, định hướng và điều kiển bởi Data governance. Đây chính là nguyên nhân khiến nhiều người nhầm lẫn giữa 2 khái niệm. Nếu Data management là tập hợp các chức năng, quy trình mà một công ty triển khai để quản lý dữ liệu, thì Data governance lại có vai trò liên kết và quản lý tất cả các chức năng, quy trình ấy.

- Data federation

Data federation nếu dịch chính xác theo tiếng Việt có nghĩa là “liên đoàn dữ liệu”, nghe có vẻ không “hợp tai” nhưng có nghĩa bao quát là công cụ liên kết dữ liệu. Data federation là loại hình đặc biệt khác của Data integration. Data integration hỗ trợ chuyển đổi, tích hợp tất cả các dữ liệu khác nhau vào một nơi lưu trữ thống nhất có yêu cầu về cùng tính chất, đặc điểm, điều kiện nào đó,… tức là có việc di chuyển và lưu trữ dữ liệu để dùng cho việc phân tích sau này. Trong quá khứ, các công ty lưu trữ trong các kho dữ liệu gọi là Data warehouse, còn hiện nay có xu hướng lưu trữ trong Data lake (hồ dữ liệu). Sự khác biệt giữa Data lake và Data warehouse: Data warehouse biến đổi, lưu trữ dữ liệu từ các nguồn khác nhau, và những dữ liệu này có cấu trúc rõ ràng, Data lake lưu trữ dữ liệu chưa qua phân tích hay còn gọi là dữ liệu thô. Data federation là một dạng tích hợp ảo tức là các chuyên gia có thể thông qua đó có thể nhìn vào và thấy được các dữ liệu kết hợp khi nào cần mà không cần phải di chuyển và lưu trữ chúng vào một nơi. Các phần mềm Data federation tạo ra các virtual database (cơ sở dữ liệu ảo) cho phép chúng ta tham chiếu dữ liệu, xử lý trực tiếp dữ liệu, thực hiện các phân tích kinh doanh thông minh (Business Intelligence) hay các phân tích thông thường mà không cần phải sao chép, luân chuyển, lưu trữ qua đó tăng mức độ bảo mật, an toàn thông tin, đặc biệt có chức năng như cung cấp quyền truy cập, mã hóa dữ liệu,…

- Master data management

Quản lý dữ liệu chủ hay còn gọi là Master data management. Master data, dữ liệu chủ, theo định nghĩa của Gartner, một công ty đi đầu trong lĩnh vực nghiên cứu và tư vấn giải pháp, là một tập hợp các định danh (identifiers) và thuộc tính thống nhất mô tả các thành phần cốt lõi của tổ chức, công ty như khách hàng, sản phẩm, tài sản, nhân viên, nhà cung cấp, các cấp chi nhánh, bộ phận chức năng, các website,…Ví dụ mã số khách hàng, số điện thoại, địa chỉ khách hàng cung cấp thông tin mô tả về khách hàng được coi là master data. Master data management là một tập hợp các quy trình, các công nghệ, phương pháp hỗ trợ quản lý dữ liệu chủ để việc chia sẻ dữ liệu, luân chuyển dữ liệu giữa tất cả các bộ phận, thành phần bên trong tổ chức diễn ra hiệu quả hơn. Lợi ích của quản lý dữ liệu chủ và tầm quan trọng của nó, BigDataUni sẽ bàn luận chi tiết hơn ở các bài viết sắp tới.

- Data preparation

Chuẩn bị dữ liệu cho các mục đích phân tích, mục đích sử dụng khác nau này cũng là chức năng quan trọng trong Data management. Data preparation nhiệm vụ tổng hợp, tích hợp dữ liệu từ nhiều nguồn khác nhau (có thể cho rằng bao gồm cả Data integration), chọn lọc, chuyển đổi, dữ liệu trước khi được phân tích và sử dụng trong các quy trình kinh doanh. Data preparation còn được gọi là quá trình chuẩn bị và đưa dữ liệu vào sử dụng sau khi đã thu thập, lưu trữ, quản lý. Không có một công việc, kế hoạch nào diễn ra thành công nếu không có sự chuẩn bị từ trước, phân tích dữ liệu cũng vậy, trước khi phân tích mỗi công ty phải tiến hành các bước chuẩn bị dữ liệu một cách hoàn chỉnh. Dữ liệu thu thập thường rất lớn, trong đó lại chứa nhiều dữ liệu không liên quan, dữ liệu bị hỏng, dữ liệu không đầy đủ, dữ liệu không chứa thông tin, giá trị (missing value hay null value),.. cần được xử lý trước. Theo các chuyên gia IBM, thời gian thực hiện quá trình chuẩn bị dữ liệu là nhiều nhất, chiếm gần 90% tổng thời gian dành cho mỗi dự án phân tích dữ liệu. Qua đó cho thấy tầm quan trọng của Data preparation, vì nó quyết định kết quả phân tích sau cùng có chính xác hay không, kết luận sau cùng dữ liệu có đem lại các giá trị, thông tin hữu ích hay không? Bên trên là các chức năng, thành phần, những quá trình mà công ty SAS cho rằng là không thể thiếu của một hệ thống Data management. Dưới đây là một tập hợp các chức năng, quy trình đầy đủ nhất của Data management theo DAMA (Theo The Global Data Management Community), trích dẫn trong The Data Management Body of Knowledge (DMBOK, phiên bản 2, năm 2017)

- Data governance

Tương tự đã nói ở trên, Data governance là lập kế hoạch, triển khai, giám sát toàn bộ hoạt động, các quy trình, chức năng có trong quản lý tài sản dữ liệu, kiểm soát hệ thống Data management. DAMA đặt Data governance vào trung tâm của vòng tròn Data management (DAMA Wheel), vì Data governance đóng vai trò là “trái tim”, thành phần cốt lõi, ổn định, cân bằng tất cả các chức năng trong Data management.

The DAMA Wheel (DMBOK phiên bản 2)

- Data architecture management

Liên quan đến các công việc: xác định nhu cầu, tiến hành thiết kế, duy trì và phát triển hệ thống kiến trúc dữ liệu bao gồm các mô hình, chính sách, quy tắc hoặc tiêu chuẩn tác động đến cách thức dữ liệu được thu thập, lưu trữ, sắp xếp, tích hợp, và đưa vào phân tích, sử dụng.

- Data modelling and design

Thiết kế và mô hình hóa dữ liệu là quá trình khám phá, nghiên cứu, phân tích dữ liệu, xác định, tìm hiểu các nhu cầu, mục đích khai thác dữ liệu, thể hiện những nhu cầu, mục đích ấy vào các mô hình dữ liệu thống nhất, chuẩn tắc, có thể được sử dụng nhiều lần, lặp đi lặp lại trong tương lại. Data modelling đại diện cho đối tượng dữ liệu, thể hiện mối liên hệ, sự kết hợp giữa các đối tượng dữ liệu khác nhau và các quy tắc có thể có giữa chúng.

- Data storage and operations

Lưu trữ và vận hành dữ liệu bao gồm việc thiết kế, triển khai, hỗ trợ lưu trữ dữ liệu, mục đích tối đa hóa giá trị trong suốt vòng đời của chúng, từ việc tiếp cận, thu thập, tích hợp đến xử lý. Lưu trữ và vận hành dữ liệu bao gồm hai hoạt động phụ. Thứ nhất, Database support, tập trung vào các hoạt động liên quan đến vòng đời dữ liệu, từ việc triển khai xây dựng môi trường cơ sở dữ liệu ban đầu, đến việc thu thập, lưu trữ, hay loại bỏ dữ liệu, đảm bảo cơ sở dữ liệu được hoạt động tốt thông qua giám sát, và điều chỉnh. Thứ hai, Database technology support, xác định các nhu cầu, yêu cầu của hệ thống lưu trữ dữ liệu, xem xét với khả năng, nguồn lực hiện tại của tổ chức, xác định các phần mềm kỹ thuật, kết cấu kiến trúc sẽ áp dụng, sau đó tiến hành xây dựng, cài đặt và quản trị các phần mềm, và giải quyết các vấn đề phát sinh liên quan đến kỹ thuật trong tương lai.

- Data security

Data security, bảo mật dữ liệu, bao gồm các công việc lập kế hoạch, phát triển và thực hiện các chính sách và quy trình bảo mật, cung cấp các cách thức xác thực, ủy quyền, truy cập và kiểm soát, thống kê, báo cáo về dữ liệu và tài sản thông tin. Các chi tiết cụ thể về quy trình Data security (ví dụ dữ liệu cần được bảo vệ) khác nhau giữa các công ty, các ngành, lĩnh vực và thậm chí giữa các nước (do mỗi nước có những bộ luật riêng về an ninh mạng, an toàn dữ liệu,..) Tuy nhiên, mục tiêu của các hoạt động bảo mật dữ liệu là như nhau: bảo vệ tài sản thông tin, dữ liệu, tuân thủ các quy định về quyền riêng tư, bảo mật, các yêu cầu, thỏa thuận khác trong kinh doanh.

- Data integration and interoperability

Tích hợp dữ liệu và khả năng tương tác mô tả các quá trình liên quan đến sự di chuyển và hợp nhất dữ liệu bên trong và giữa các hệ thống lưu trữ, các ứng dụng và tổ chức. Định nghĩa của Data integration ở đây tương tự với Data integration đã nói ở phía trên nên chúng tôi sẽ không đề cập lại. Còn Data interoperability chính là khả năng các hệ thống tương tác, “giao tiếp”, trao đổi dữ liệu, thông tin với nhau.

- Document and content management

Document and content management (quản lý tài liệu, nội dung) liên quan đến kiểm soát quá trình thu thập, lưu trữ, truy cập và sử dụng các tài liệu, thông tin ở bên ngoài cơ sở dữ liệu. Mục đích là duy trì tính toàn vẹn và cho phép người dùng truy cập và sử dụng dữ liệu và thông tin phi cấu trúc hoặc bán cấu trúc. Trong nhiều tổ chức, dữ liệu phi cấu trúc có mối quan hệ trực tiếp với dữ liệu có cấu trúc do đó cần thiết lập các kế hoạch hành động cụ thể, triển khai và giám sát. Ngoài ra, cũng như các loại dữ liệu khác, tài liệu và nội dung phi cấu trúc cần được kiểm tra về chất lượng và bảo mật.

- Reference and master data

Các phòng ban, bộ phận, các quy trình, hệ thống trong một tổ chức đều yêu cầu chia sẽ dữ liệu để sử dụng với nhiều mục đích khác nhau. Mặc dù lợi ích mà chia sẻ dữ liệu đem lại là rất nhiều, nhưng vẫn tiềm ẩn rủi ro và vấn đề khác nhau như dữ liệu trao đổi có thể bị trùng lặp, dư thừa; chất lượng dữ liệu có thể bị ảnh hưởng; và các chi phí liên quan khác có thể gia tăng. Đó là lý do vì sao các tổ chức cần quản lý reference data và master data hiệu quả. Chúng tôi đã giới thiệu về master data trong Master data management ở phần trước nên không nhắc lại ở đây. Còn Reference data, dữ liệu tham chiếu, là các bảng mã, dữ liệu mô tả, phân loại dữ liệu khác bên trong tổ chức hoặc liên quan đến dữ liệu, thông tin khác ngoài phạm vi tổ chức.

Ví dụ, để phân loại dữ liệu khách hàng tiềm và để thuận tiện sàng lọc, tham chiếu, chúng ta có thể đặt mã là dòng chữ viết tắt như “KHTN” hoặc tiếng anh “PC” – potential customer; để miêu tả đơn vị tiền tệ của các quốc gia chúng ta có “VND” – Việt Nam Đồng, “USD” – US Dollars, đây là ví dụ Reference data liên quan đến dữ liệu bên ngoài phạm vi tổ chức.

- Data warehousing and Business Intelligence

Data warehousing and Business Intelligence liên quan đến việc lập kế hoạch, thực hiện và kiểm soát các quy trình để cung cấp dữ liệu hỗ trợ ra quyết định và hỗ trợ lập báo cáo, truy vấn và phân tích dữ liệu. Data warehousing mô tả các quá trình trích xuất, làm sạch, chuyển đổi, kiểm soát, truyền tải dữ liệu,… trong kho dữ liệu. Business Intelligence (BI) là các quy trình, cách thức sử dụng dữ liệu để hỗ trợ các nhà quản lý trong các công ty đưa ra các quyết định về kinh doanh hay còn gọi là Business decisions. BI được coi là thuật ngữ phổ biến để miêu tả các cách sử dụng dữ liệu phục vụ cho việc dự báo môi trường kinh doanh thông qua các bước phân tích để nắm bắt, phát hiện các vấn đề kinh doanh trong dữ liệu, tiến hành đưa ra các hành động, giải pháp cụ thể.

- Metadata management

Quản lý metada liên quan đến lập kế hoạch, triển khai và kiểm soát các hoạt động truy cập, sử dụng metadata. Ở bài viết trước về Data mining “Quy trình và phương pháp”, BigDataUni đã giới thiệu về metadata – siêu dữ liệu, xin nhắc lại ở đây.

Metadata là loại dữ liệu dùng để mô tả các dữ liệu khác, như mô tả tính chất, loại biến dữ liệu, thông tin mà dữ liệu đó cung cấp,…Cùng với reference data và master data, metadata hỗ trợ các quá trình xử ly, tích hợp, bảo mật, kiểm soát, chia sẻ dữ liệu diễn ra hiệu quả và chính xác hơn. Ngoài ra metadata còn giúp chùng ta hiểu rõ hơn về dữ liệu, đánh giá chất lượng dữ liệu, quản lý các cơ sở dữ liệu, các ứng dụng tốt hơn.

- Data quality management

Việc lập kế hoạch, thực hiện và kiểm soát các hoạt động áp dụng những kỹ thuật quản lý chất lượng vào dữ liệu, để đảm bảo nó phù hợp để phân tích và đáp ứng nhu cầu của người dùng, khái niệm gần giống với Data quality đã nói ở trên

Đến đây là kết thúc phần 1 bài viết về “Tầm quan trọng của Data management”, ở phần 2 bài viết sắp tới BigDataUni sẽ đi vào trọng tâm nói về các lợi ích, cũng như thách thức Data management đem lại, đặc biệt là các giải pháp triển khai Data management hiệu quả.

Update phần 2: TẦM QUAN TRỌNG CỦA QUẢN LÝ DỮ LIỆU (DATA MANAGEMENT) (P2)

Nguồn tham khảo cho bài viết:

- Website

blogmarketers.wordpress.com/2015/03/23/data-management-platform-la-gi-hay-dmps-la-gi/

http://mona-media.com/dmp-la-gi/

https://techinsight.com.vn/xay-dung-nen-tang-du-lieu-data-management-platform/

https://www.sas.com/en_us/insights/data-management/data-management.html

https://www.sas.com/en_us/insights/articles/data-management/data-management-backgrounder.html

https://searchdatamanagement.techtarget.com/definition/data-management

https://www.talend.com/resources/what-is-data-management/

https://www.dataversity.net/what-is-data-management/

- Tài liệu

The Data Management Body of Knowledge (DMBOK, phiên bản 2, năm 2017) của DAMA

Về chúng tôi, công ty BigDataUni với chuyên môn và kinh nghiệm trong lĩnh vực Big Data sẵn sàng hỗ trợ các công ty đối tác trong việc xây dựng và quản lý hệ thống dữ liệu một cách hợp lý, tối ưu nhất để hỗ trợ cho việc phân tích, khai thác dữ liệu và đưa ra các giải pháp. Các dịch vụ của chúng tôi bao gồm “Tư vấn và xây dựng hệ thống dữ liệu”, “Khai thác dữ liệu dựa trên các mô hình thuật toán”, “Xây dựng các chiến lược phát triển thị trường, chiến lược cạnh tranh”.

Nếu các bạn có bất kỳ thắc mắc nào xin đừng ngần ngại liên hệ chúng tôi tại mục liên hệ hoặc comment trực tiếp dưới bài viết.

English

English