Ở bài viết phần 1 chúng ta đã đi vào bài viết đầu tiên về chủ đề Clustering, thuật toán phân cụm với việc tìm hiểu về khái niệm, lợi ích, ứng dụng phổ biến của thuật toán trong thực tế, đặc biệt là trình bày sơ lược về 2 phương pháp thông dụng trong clustering là Hierarchical clustering (Agglomerative method) và Partitioning clustering (tập trung vào K-means clustering). Trong bài viết phần 2 lần này, chúng ta sẽ đi vào ví dụ cụ thể để hiểu hơn về cách triển khai cũng như cách vận hành của thuật toán.

Bạn nào chưa xem bài viết phần 1 có thể tham khảo qua link dưới đây

Tìm hiểu về phương pháp Clustering (phân cụm) (P.1)

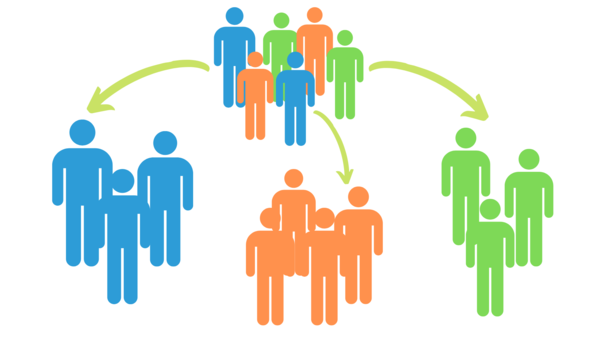

Như đã đề cập ở bài viết trước, một trong các ứng dụng chính của Clustering được các công ty sử dụng nhiều nhất đó là hỗ trợ các hoạt động marketing, bán hàng hiệu quả thông qua việc phân khúc khách hàng – Customer segmentation – một cách tối ưu dựa trên những dữ liệu thông tin cá nhân, dữ liệu giao dịch, dữ liệu hành vi của khách hàng có thể thu thập được.

Nguồn hình: Liveagent.com

Vậy lý do tại sao cần phân khúc khách hàng? Nó giúp ích gì cho marketing và sales?

Có nhiều lý do thúc đẩy các công ty phân khúc khách hàng trong đó tập trung vào mục đích sau cùng là việc tối ưu chiến lược marketing và sales mà ở đó tỷ lệ chuyển đổi hay còn gọi tỷ lệ khách hàng tham gia dịch vụ, giao dịch tăng cao dẫn đến doanh thu sẽ tăng.

Nhờ vào những phân khúc khách hàng tìm được các công ty sẽ có thể:

- Phân biệt được những khách hàng công ty đang có, xác định được nhóm khách hàng nào cần tập trung, kiểm soát hay đánh giá các hoạt động CRM

- Xây dựng các nội dung marketing, nội dung quảng cáo nhắm mục tiêu cụ thể, có sự liên quan phù hợp với nhu cầu của từng phân khúc khách hàng cụ thể, tăng trải nghiệm khách hàng thông qua tương tác cá nhân hóa từ đó tăng khả năng giữ chân khách hàng.

- Khám phá các cơ hội kinh doanh mới, cơ hội bán thêm được các sản phẩm mới thông qua Cross-selling hay Up-selling khi biết được một phân khúc khách hàng có thể ưa chuộng nhiều dòng sản phẩm khác, khám phá được thị trường mới từ các phân khúc khách hàng trước đây chưa từng phát hiện

- Điều chỉnh các chiến lược về giá, sản phẩm sau khi thấy có sự khác biệt giữa những phân khúc khách hàng trong quá trình giao dịch từng sản phẩm cụ thể.

- Điều chỉnh chiến lược phân phối, kênh bán hàng sau khi xác định được địa điểm mua hàng chủ yếu, mức tiêu thụ từng sản phẩm của các phân khúc khách hàng khác nhau

- Gia tăng lợi thế cạnh tranh trước đối thủ nhờ vào các hoạt động marketing, tương tác nhanh chóng với các khách hàng dựa trên thông tin có được từ việc phân tích các phân khúc. Hình ảnh thương hiệu, sự uy tín cũng sẽ tăng nếu khách hàng luôn cảm thấy được sự ân cần, quan tâm từ phía công ty, và tìm được thứ họ cần trong thời gian nhanh nhất.

Trong bài viết phần 2, và phần 3, các ví dụ triển khai thuật toán Hierarchical và Partitioning Clustering sẽ tập trung vào hoạt động marketing ở các công ty. Bài viết phần 2 lần này chúng ta sẽ đi vào ví dụ đơn giản trước để hiểu cách vận hành Hierarchical clustering. Bài viết phần 3 sẽ tập trung vào K-means clustering mô hình RFM phức tạp hơn.

Lưu ý lần nữa với các bạn: Các dạng Hierarchical Clustering và Partitioning Clustering có nhiều phương pháp khác nhau, và mỗi phương pháp đều có ưu và khuyết điểm riêng của mình. Hướng tiếp cận của bài viết về chủ đề clustering lần này sẽ tập trung trước vào các thuật toán clustering phổ biến, đơn giản, dễ hiểu, dễ thực hiện và không phức tạp trong tính toán, dành cho các bạn đang tìm hiểu Data mining và lý thuyết cơ bản trong clustering. Clustering là một trong các phương pháp phân tích cực kỳ quan trọng trong Data science và dĩ nhiên khối lượng kiến thức là rất nhiều, không thể trình bày gói gọn trong một vài bài viết.

Đối với những dạng clustering tinh vi, phức tạp hơn chúng tôi chắc chắn sẽ gửi đến các bạn ở các bài viết khác khi có dịp.

Hierarchical clustering (Agglomerative method)

Như đã đề cập ở bài viết trước, đối với phương pháp phân cụm có cấu trúc chúng ta sẽ có 2 dạng chính Agglomerative (gom tụ) và Divisive (phân tách) trong đó được sử dụng phổ biến hơn cả là dạng gom cụ.

Với Agglomerative, bắt đầu mỗi quan sát là một cụm nhỏ của riêng nó. Sau đó, trong các bước tiếp theo, hai cụm gần nhất được tổng hợp thành một cụm kết hợp mới. Bằng cách này, số lượng cụm trong tập dữ liệu sẽ giảm đi một ở mỗi bước. Cuối cùng, tất cả các cụm được kết hợp thành một cụm lớn duy nhất.

Agglomerative khi triển khai chúng ta cần xem xét cách gom các quan sát thành từng cụm, và cách gom từng cụm lại thành cụm lớn mà đảm bảo tuân theo cách tính toán khoảng cách với nguyên lý khoảng cách gần thì thể hiện sự tương đồng. Có nhiều cách gom hay còn gọi linkage như Single –linkage (gom cụm theo khoảng cách ngắn nhất), Complete – linkage (gom cụm theo khoảng cách xa nhất), Average – linkage (gom cụm theo khoảng cách trung bình). Các cách gom cụm này là theo phương pháp đồ thị (Graph methods). Ngoài ra còn có các cách gom cụm theo phương pháp hình học như Ward’s, Centroid, Median (Geometric methods), các bạn có thể tham khảo ở những tài liệu khác. Trong series clustering lần này chúng ta sẽ chỉ tập trung vào các phương pháp đồ thị đặc biệt là Single – linkage, dạng cơ bản nhất. Các dạng còn lại chúng tôi sẽ trình bày ở những bài viết khác trong tương lai nếu có dịp.

- Single – linkage

Quy trình triển khai thuật toán có thể tóm gọn theo các bước sau:

- Xem mỗi object, mỗi đối tượng quan sát là một cluster con, hay cluster đơn lẻ. Lúc này một cluster chỉ có 1 quan sát

- Tính toán khoảng cách giữa các cluster đơn lẻ, highlight những giá trị nhỏ nhất để tiện cho quá trình gom cụm dễ dàng hơn

- Tiến hành gom cụm từng cặp cluster theo quy tắc khoảng cách nhỏ nhất.

- Bước 3 cứ tiếp tục cho đến khi chỉ còn 1 cluster duy nhất chứa tất cả các object

- Biểu diễn kết quả trên Dendogram và xác định vị trí ngắt nhánh để tìm số các cluster muốn tìm. Lưu ý: khác với Partitioning clustering, phân cụm theo cấu trúc không cho chúng ta biết có bao nhiêu cluster thực sự.

Để minh họa các cách linkage chúng ta cùng đi qua ví dụ minh họa sau:

Một công ty tài chính tại Hoa Kỳ mới nhận được thông tin đăng ký tư vấn về đầu tư quỹ tài chính trên website từ 20 khách hàng. Thông tin được cung cấp bởi các khách hàng là khác nhau. Để nhanh chóng phân công cho các chuyên viên tư vấn những nhóm khách hàng để họ phụ trách sao cho hiệu quả, khi mỗi chuyên viên có năng lực giao tiếp, thuyết phục khách hàng không giống nhau. Dữ liệu bao gồm tên, tuổi, nghề nghiệp, thu nhập hàng tháng, khoản đầu tư mong muốn, nơi cư trú, số điện thoại. Giả sử công ty quan tâm đến thu nhập hàng tháng, và khoản đầu tư mong muốn để phân khúc khách hàng. Biến nghề nghiệp cũng quan trọng tuy nhiên trong chủ đề clustering lần này chúng tôi chỉ tập trung vào trường hợp ứng dụng clustering cho dữ liệu định lượng trước.

Đơn vị tính: USD. Chúng ta sẽ tập trung vào 2 biến Income hàng tháng và khả năng đầu tư quỹ Investment.

Bước đầu tiên khi triển khai thuật toán clustering thông thường sẽ phải chuẩn hóa dữ liệu (Normalization) nếu dữ liệu có các thang đo hay đơn vị đo khác nhau và giữa chúng có sự chênh lệch lớn, khó khăn cho việc tính toán và đôi khi kết quả phân tích không được hợp lý. Chuẩn hóa dữ liệu biến đổi những dữ liệu định lượng với những đơn vị đo khác nhau thành một thang đo chuẩn sẽ giúp nhìn bài toán cần phân tích gọn hơn và khắc phục các vấn đề trên.

Công thức tiêu chuẩn của chuẩn hóa dữ liệu:

Cách tính khá đơn giản, bạn phải tìm được trung bình mẫu, độ lệch chuẩn mẫu và ghép vô công thức, giá trị x đầu tiên là giá trị cần chuẩn hóa.

Dưới đây là kết quả sau khi chuẩn hóa các bạn có thể check thử

Bảng dữ liệu 2 biến Income và Investment đã được chuẩn hóa.

Tiếp theo chúng ta sẽ lập bảng ma trận khoảng cách theo công thức Euclidean, bảng ma trận còn được gọi là Proximity Matrix:

Việc tính toán Euclidean giữa các object các bạn có thể thực hiện bằng Excel hoặc nhanh hơn có thể sử dụng SPSS – bạn nào học thống kê chắc cũng biết đến. Nếu các bạn có SPSS cho phép thực hiện nhanh chóng thuật toán: Analyze/ Classify/ Hierarchical Clustering/ Statistics/ chọn Proximity matrix.

Như vậy chúng ta đã làm xong bước 2, lúc này mỗi khách hàng sẽ là 1 cluster, chúng ta sẽ sang bước 3 tiến hành gom cụm

Với single – linkage chúng ta sẽ gom cụm theo phương pháp khoảng cách ngắn nhất giữa 2 object bất kỳ thuộc các cluster. Các bạn xem lại bảng giá trị khoảng cách euclidean tính được ở trên. Highlight những giá trị nhỏ nhất (tốt hơn nên xét theo thứ tự), xem giá trị đó tính được giữa 2 khách hàng nào rồi tiến hành gom cặp, nếu một khách hàng đã thuộc 1 cluster trước đó, thì khách hàng còn lại cũng sẽ thuộc cluster này.

Có 2 cách thực hiện:

1) Theo cách xây dựng đồ thị Dendrogram, sắp xếp theo thứ tự giá trị khoảng cách từ nhỏ nhất đến lớn nhất, rồi tiến hành gom cụm, sử dụng duy nhất 1 bảng ma trận khoảng cách.

2) Xem xét từng ID có khoảng cách gần nhất với ai rồi gom cụm. Sau đó sử dụng chính bảng ma trận khoảng cách để tính toán lại khoảng cách với các cluster mới. Cách này phức tạp khi dữ liệu có nhiều quan sát, vì sẽ phải lập lại bảng ở mỗi bước và không dễ vẽ đồ thị nếu yêu cầu phân tích là thể hiện kết quả bằng Dendogram. Nguyên nhân là chúng ta phải sắp xếp thứ tự các bảng, và các giá trị khoảng cách theo thứ tự gom gụm (nếu chỉ nhìn bảng có thể nhầm lẫn).

Nói chung sẽ có nhiều hướng tiếp cận, bạn cũng có thể linh hoạt tự sáng tạo cho riêng mình, chỉ cần đảm bảo nguyên tắc của linkage function mà ở đây là Single-linkage.

Để nhanh chóng và không làm bài viết có quá nhiều bảng, chúng tôi sẽ làm theo cách 1, và hướng dẫn cách vẽ Dendrogram.

Ví dụ theo bảng khoảng cách giữa ID 3 và ID 15 là nhỏ nhất, chỉ có giá trị 0, nhỏ nhất (các bạn xem lại tập dữ liệu sẽ thấy khách hàng số 3 và 15 có income và investment tương tự nhau), nên gom ID 3 và ID 15 vào 1 cụm

Tiếp theo khoảng cách giữa ID 8 và ID 18, và khoảng cách giữa ID 9 và ID 11 có giá trị nhỏ nhất thứ 2 là 0.2, như vậy chúng ta sẽ có thêm 2 cluster nữa.

D(ID 3, ID 15) = 0

D(ID 8, ID 18) = 0.2

D(ID 9, ID 11) = 0.2

Tiếp theo, dựa trên bảng số liệu chúng ta thấy, ID 18 và ID 14 có giá trị khoảng cách nhỏ nhất tiếp theo là 0.361.

D({ID 8, ID 18}, ID 14) = min{d(ID 8, ID 14), d(ID 18, ID 14)} = 0.361. Lúc này ID 14 sẽ cùng cluster (ID 8, ID 18).

Giải thích: Vì 0.361 là giá trị khoảng cách nhỏ nhất tiếp theo được xét đến và ID 14 có khoảng cách gần với ID 8 nhất sau ID 18 (hay có khoảng cách gần với ID 18 nhất sau ID 8) thỏa điều kiện Single – linkage nên chúng ta có thể gom cụm, giải thích tương tự cho những trường hợp sau. Các bạn lưu ý nhé!

Lưu ý: cách viết theo công thức như trên chỉ thể hiện thông tin về khoảng cách giữa các cluster để so sánh khi gom cụm, ở đây chúng tôi chỉ viết 1 dòng thông tin cho nhanh sẽ gom cụm nào thay vì phải viết ra (nếu làm cách 2, còn theo cách xây dựng Dendrogram thì không cần vì chúng ta xét từng giá trị nhỏ nhất theo thứ tự). Ví dụ: D({ID 8, ID 18}, ID 14), D({ID 8, ID 18}, ID 10), D({ID 8, ID 18}, ID 11),… rồi so sánh cái nào có giá trị nhỏ nhất sẽ tiến hành gom cụm

Sau giá trị khoảng cách 0.361, giá trị nhỏ nhất tiếp theo là 0.4, là giá trị khoảng cách giữa ID 1 và ID 7, cũng là giá trị khoảng cách giữa ID 4 và ID 10; ID 3 và ID 20. Ngoài ra lúc này chúng ta sẽ thấy khoảng cách giữa ID 6 và ID 7 cũng sẽ bằng 0.4 (ID 6 có khoảng cách gần với ID 7 nhất sau ID 1), trong khi ID 3 đã thuộc cluster (ID 3, ID 15) trước đó. Như vậy:

D({ID 1, ID 7}, ID 6) = min{d(ID 1, ID 6), d(ID 7, ID 6)} = 0.4

D({ID 3, ID 15}, ID 20) = min{d(ID 3, ID 20), d(ID 15, ID 20)} = 0.4

Sau giá trị 0.4, chúng ta xét đến giá trị nhỏ nhất tiếp theo là 0.5. Đây là khoảng cách giữa ID 4 và ID 6, cũng chính là khoảng cách giữa ID 10 và ID 7. Trong khi ID 4, ID 10 thuộc cluster (ID 4, ID 10), ID 6, ID 7 giờ thuộc cluster (ID 1, ID 7, ID 6). Như vậy chúng ta sẽ gom 2 cụm này với nhau:

D({ID 4, ID 10}, {ID 1, ID 6, ID 7}) = min{d((ID 1, ID 6, ID 7), ID 4), d(((ID 1, ID 6, ID 7), ID 10)} = min {d(ID 1, ID 4), d(ID 6, ID 4), d(ID7, ID 4), d(ID 1, ID 10), d(ID 6, ID 10), d(ID 7, ID 10)} = 0.5

Chúng ta sẽ tiếp đồ thị như sau:

Các bạn xét tiếp những giá trị nhỏ nhất tiếp theo, xem đó là khoảng cách giữa ID nào với ID nào, thuộc cluster nào trước đó hay không để gom cụm tiếp. Dưới đây là kết quả sau cùng, từ SPSS:

Cột phải là ID, dòng trên cùng là khoảng cách giữa các cluster đã được scale lại. Trên đồ thị tất cả các ID đều nằm trong 2 nhánh lớn nhất: một nhánh có cluster (ID 5, ID 12) và nhánh lớn còn lại chứa tất cả các ID còn lại.

Câu hỏi đặt ra có tổng cộng bao nhiêu cluster và mỗi cluster thể hiện tính chất gì?

Việc ngắt nhánh để xác định số cluster còn phụ thuộc vào mục đích và mong muốn của người phân tích ví dụ ở công ty này họ có 4 chuyên viên tư vấn vậy không nên có quá 4 clusters.

Ở đây chúng tôi sẽ ngắt tại vị trí có giá trị khoảng cách = 15

Chúng ta có các cluster sau, lưu ý sẽ có các cluster chỉ có 1 object:

Cluster 1( ID 3, ID 15, ID 20, ID 19, ID 8, ID 18, ID 14, ID 9, ID 11) có Income trung bình là 13000 USD và nhu cầu đầu tư trung bình gần 5000 USD. Đây là nhóm tiềm năng, và công ty cần tập trung vì những khách hàng này có thu nhập, và vị trí công việc ở cấp bậc cao, có kiến thức kinh doanh khi đa số là quản lý, nhà kinh doanh và là chuyên gia tư vấn. Họ có thu nhập cao, có nhu cầu đầu tư nhưng không cao có thể do cân nhắc kỹ lợi nhuận thu về, hoặc do mới tham gia đầu tư hoặc đã có kinh nghiệm, dự báo được rủi ro, giá trị nhận về. Các chuyên viên nào phụ trách nhóm này cần vừa vững về kiến thức chuyên môn đầu tư tài chính, vừa có kinh nghiệm, có thể chỉ ra những lợi ích dài hạn khi các khách hàng này đầu tư nhiều hơn nữa, và có khả năng giao tiếp tốt, biện luận tốt, năng lực thuyết phục khách hàng tốt.

Cluster 2 (ID 4, ID 10, ID 6, ID 7, ID 1, ID 2) có Income trung bình là 11600 USD, và nhu cầu đầu tư trung bình 2600 USD, nhỏ hơn gần 1 nữa so với cluster 1. Nghề nghiệp chính của nhóm này đa số là quản lý các cửa hàng, first-line manager. Họ cũng có kiến thức kinh doanh, thu nhập cao trên 10000 USD 1 tháng nhưng có thể họ mới tham gia thị trường đầu tư tài chính nên còn e dè, mơ hồ, dẫn đến lo ngại về rủi ro. Chuyên viên tư vấn không nhất thiết phải cần nhiều kinh nghiệm, hay chuyên môn rất cao về đầu tư tài chính tuy nhiên rất cần năng lực giao tiếp, giải thích đơn giản, dễ hiểu, ngắn gọn, nhưng đủ thông tin về lợi ích mà khách hàng có thể nhận được và có sức ảnh hưởng, có tính thuyết phục.

Cluster 3 (ID 16, ID 17), hai khách hàng này có nhu cầu đầu tư rất cao, trung bình trên 7000 USD, kể cả thu nhập hàng tháng cũng cao trên 13000 USD. Các khách hàng này có thể đã có kinh nghiệm đầu tư tài chính hoặc trước đây từng là khách hàng cũ, họ sẵn sàng đầu tư mạnh. Chuyên viên tư vấn không cần cố gắng thuyết phục họ đầu tư, chỉ cần nêu rõ các quyền lợi họ nhận được khi tham gia đầu tư, giới thiệu thêm những dịch vụ chăm sóc đặc quyền dành cho họ,… cho thấy họ đang được quan tâm nhiều hơn so với các khách hàng thông thường.

Sau khi phân được 3 cluster chúng ta còn 3 khách hàng đứng riêng lẻ, mỗi khách hàng đại diện cho cluster của chính nó:

Khách hàng ID 13 khách hàng này có thu nhập cao thứ 3 trong danh sách là 16800 USD tuy nhiên họ có nhu cầu đầu tư thấp chỉ có 4000 USD, mà nghề nghiệp khách hàng này lại là chuyên gia tư vấn, có thể có kiến thức chuyên môn đầu tư tài chính. Họ đầu tư thấp có thể họ phân bổ đầu tư ở các công ty khác, có khả năng đánh giá, so sánh giữa các công ty tài chính trước khi đầu tư, hoặc có thể thấy được vấn đề công ty đang gặp phải nên dự báo được rủi ro, và có sự dè chừng. Chuyên viên tư vấn phải tạo mối quan hệ thân thiết hơn thông thường vì khả năng khách hàng này có tiềm năng tham gia các hợp đồng đầu tư dài hạn, có giá trị lớn, phải khôn khéo, có thể khiến vị khách hàng này nói được tại sao họ đầu tư thấp, những vấn đề gì họ thấy ở công ty mình, họ là chuyên gia tư vấn có thể đóng góp ý kiến gì không. Nói chung chuyên viên tư vấn phải là người tinh tế, có kinh nghiệm rất cao, cả về kiến thức chuyên môn, lẫn các kỹ năng đàm phán, trao đổi ở mức tốt nhất.

Còn khách hàng ID 5, ID 12, 2 khách hàng này không nằm trong cùng cluster, nhưng công ty có thể gom lại thành nhóm do có cùng thu nhập cao nhất trung bình trên 17000 USD, và nhu cầu đầu tư rất cao trên 8000 USD. Chuyên viên tư vấn phụ trách giống như cluster 3 tuy nhiên có khác biệt là 2 khách hàng này có thu nhập cao nên có thể thuyết phục họ đầu tư nhiều hơn hoặc cung cấp thêm các dịch vụ khác vì khả năng cao họ sẽ đầu tư thêm

Bên trên chỉ là ví dụ giải thích cho bạn ứng dụng clustering như thế nào, còn trong thực tế phải xét đến nhiều yếu tố khác ví dụ ở đây chúng tôi chưa nói đến yếu tố tuổi tác, gia đình,… chuyên viên tư vấn trẻ có thể phụ trách tập khách hàng có độ tuổi thấp và ngược lại. Công ty còn phải dựa vào mục đích, chiến lược kinh doanh, khả năng phát triển đội ngũ tư vấn. Ngoài ra còn có yếu tố khách quan cần xem xét, ví dụ trong số 20 khách hàng có bao nhiêu khách hàng cung cấp thông tin chính xác vì thực chất ít ai công khai đúng thu nhập hàng tháng của mình.

Mặc dù đơn giản nhưng single – linkage có nhiều khuyết điểm trong đó có thể thấy các cluster khá “lớn” tức việc phân cụm có thể còn lỏng lẻo, không được gọn. Các phương pháp khác như Completely linkage, Average linkage hay Wald’s được đánh giá là hiệu quả hơn. Do bài viết có giới hạn nên chúng tôi chưa thể trình bày trong series clustering lần này, sẽ gửi đến các bạn những phương pháp này ở các series khác về clustering.

Minh họa sơ về phương pháp Completely – linkage:

So sánh với Dendrogram của Single – linkage các bạn có thể thấy các cluster được phân rất gọn và rõ ràng, đặc biệc là không có một ID khách hàng nào chỉ đứng riêng là 1 cluster khi chúng ta ngắt nhánh ở vị trí khoảng cách (đã được điều chỉnh) = 15. Phương pháp Completely – linkage cũng giống Single – linkage ở các bước tính toán, ghép cụm đơn lẻ với nhau lúc đầu. Chỉ khác khi ghép cụm lúc các cluster chúng ta sẽ xem xét khoảng cách xa nhất giữa 1 object trong cluster này với object còn lại sẽ được ghép vào.

Ví dụ ở single – linkage:

D({ID 8, ID 18}, ID 14) = min{d(ID 8, ID 14), d(ID 18, ID 14)} = 0.361

Ở completely – linkage:

D({ID 8, ID 18}, ID 14) = max{d(ID 8, ID 14), d(ID 18, ID 14)} = 0.5 (d(ID 8, ID 14) = 0.5))

Do đó từ lúc này các bước thực hiện sẽ khác với single – linkage, khi thứ tự giá trị khoảng cách nhỏ nhất khi xét sẽ có sự xáo trộn.

Ví dụ ở single – linkage chúng ta xét 0.2 rồi xét 0.361, đến 0.4, 0.5,… nếu trường hợp completely – linkage thì chúng ta phải xét từ 0.2, đến 0.4, 0.5,… bỏ 0.361 và ở lần xem xét, chúng ta phải xác định giá trị max thay vì min, cứ thế thứ tự giá trị sẽ thay đổi. Các bạn xem qua bảng các bước gom cụm với khoảng cách Euclidean max giữa các object

Nhiệm vụ của các bạn đây: với những cluster mới tìm được từ Dendrogram của Completely – linkage các bạn có gợi ý gì cho đội ngũ chuyên gia tư vấn của công ty? Khác biệt gì so với Single – linkage?

Đến đây là kết thúc bài viết lần này. Ở bài viết phần 3 chúng ta sẽ đi vào phần quan trọng nhất của Clustering kỳ này là K-means clustering với ứng dụng trong marketing kết hợp mô hình RFM. Bài viết phần 4 sẽ trình bày về các phương pháp đánh giá kết quả phân tích từ clustering.

Về chúng tôi, công ty BigDataUni với chuyên môn và kinh nghiệm trong lĩnh vực khai thác dữ liệu sẵn sàng hỗ trợ các công ty đối tác trong việc xây dựng và quản lý hệ thống dữ liệu một cách hợp lý, tối ưu nhất để hỗ trợ cho việc phân tích, khai thác dữ liệu và đưa ra các giải pháp. Các dịch vụ của chúng tôi bao gồm “Tư vấn và xây dựng hệ thống dữ liệu”, “Khai thác dữ liệu dựa trên các mô hình thuật toán”, “Xây dựng các chiến lược phát triển thị trường, chiến lược cạnh tranh”.

English

English