Trở lại với chủ đề về các xu hướng Big Data sẽ đi đầu trong năm 2019, ở phần 1, Big Data Uni đã đề cập về sự phát triển và thay đổi của Internet of Things (IOT), trí tuệ nhân tạo (Artificial Intelligence – AI), Machine Learning (ML) tác động như thế nào đến lĩnh vực Big Data, và một số dự báo về thị trường Big Data. Phần 2 bài viết, chúng tôi sẽ đề cập chi tiết về các xu hướng của những công cụ, cách thức hỗ trợ cho việc khai thác, tiếp cận Big Data, cùng với các vấn đề, thách thức mới trong lĩnh vực Big Data.

- Xu hướng ứng dụng phân tích dự báo (predictive analytics)

Phân tích dự báo đã ra đời từ lâu. Tuy nhiên, các tổ chức, công ty giờ đây mới nhận ra tiềm năng, giá trị thực sự của nó. Ví dụ, phân tích dự báo hành vi của người tiêu dùng giúp các công ty phát triển các chiến lược marketing phù hợp, hay các giải pháp cross-selling,..; phân tích dự báo khả năng rời dịch vụ (churn rate) của khách hàng,… Predictive Analytics có thể hỗ trợ trong nhiều ngành và lĩnh vực khác nhau ngoài kinh doanh như không chỉ được sử dụng để dự đoán các sự cố, hư hỏng của các thiết bị trong sản xuất mà còn dự đoán vòng đời của thiết bị y tế trong ngành chăm sóc sức khỏe.

Phân tích dữ liệu Big Data luôn là chiến lược quan trọng để đạt lợi thế cạnh tranh và mục tiêu phát triển. Mỗi công ty cần sử dụng nhiều công cụ phân tích cần thiết khác nhau để xử lý dữ liệu Big Data và phân tích dự báo là một trong những công cụ đầu tiên cần được sử dụng. Hơn nữa thông qua phân tích dự báo áp dụng đối với Big Data, công ty không chỉ thu được giá trị dữ liệu trong thời gian thực mà còn dự đoán các sự kiện trong tương lai để có các giải pháp phù hợp.

Nguồn dữ liệu cần khai thác ngày càng nhiều, đặc biệt là dữ liệu về người tiêu dùng sẽ tiếp tục gia tăng khi càng có nhiều công ty triển khai thương mại điện tử, bán hàng trực tuyến, phát triển các ứng dụng thông minh trên smartphone, tablet,…hay bán hàng đa kênh, tạo sự tiện ích tối đa cho người mua. Predictive analytics không chỉ đem lại kết quả dự báo trong tương lai cho mỗi công ty mà còn giúp tìm hiểu sâu hơn về tình hình hoạt động kinh doanh, thực trạng sản phẩm, dịch vụ đặc biệt là customer insight (nhu cầu thầm kín của khách hàng) ở thực tại hay tương lai gần. Trong năm 2019, predictive analytics có lẽ sẽ không còn mới mẽ thậm chí sẽ phổ biến cực kỳ rộng rãi.

- Xu hướng Data Storytelling và Data Visualization

Data Storytelling là một phương pháp để truyền đạt thông tin, kết quả phân tích phù hợp với đối tượng cụ thể, thông qua cách kể chuyện hấp dẫn, trình bày, giải thích sao cho người nghe hiểu được các vấn đề, các insight trong dữ liệu. Data Visualization (hay còn gọi trực quan hóa dữ liệu) là việc mô tả dữ liệu một các đơn giản nhất dưới dạng các hình ảnh trực quan như bảng, biểu đồ, đồ thị…Data Storytelling và Data Visualization không phải là 2 phương pháp tách biệt nhau, mà lúc nào cũng cần phải đi chung với nhau và bổ trợ cho nhau.

Ví dụ nếu chỉ có mỗi Data Visualization, chúng ta chỉ mới thấy được xu hướng thay đổi của đối tượng nghiên cứu: tăng, giảm, hay không đổi thông qua các con số, đồ thị nhưng thực chất không thể biết được nguyên nhân cụ thể tại sao và các bàn luận sâu hơn về giải pháp trong bối cảnh kinh doanh; còn nếu chỉ có mỗi Data Storytelling, chúng ta lại không thể hình dung được mức độ thay đổi, chuyển biến của đối tượng nghiên cứu một cách rõ ràng nhất: tăng đều hay tăng mạnh, giảm ít hay giảm đáng kể,…hơn nữa sẽ không thu hút được người nghe, khó khiến họ tập trung vào buổi thảo luận.

Những xu hướng này dự báo sẽ phổ biến trong năm 2019 khi các công ty đầu tư nhiều hơn để xây dựng hệ thống khai thác dữ liệu, nền tảng công nghệ hỗ trợ Big Data và Data Analytics, yêu cầu thống nhất cách thức tiếp cận thông tin dữ liệu, yêu cầu nhân viên ở các bộ phận khác có thể tham gia các cuộc họp, nắm được các kết quả phân tích để hiểu được tình hình hoạt động kinh doanh và có khả năng đề xuất được giải pháp.

Nguồn blastam.com

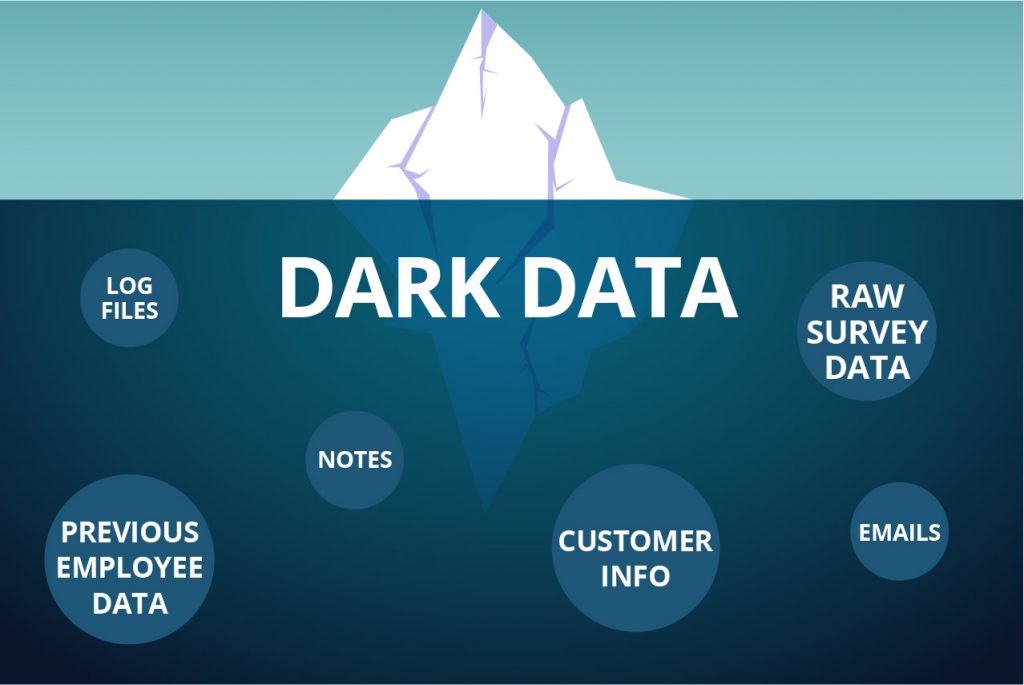

- Thách thức Dark data sẽ là thách thức lớn

Khi nhiều công ty đã bắt đầu triển khai các dự án Big Data, hay Data Analytics thì thách thức lớn đối với quá trình phân tích dữ liệu chính là thách thức Dark data. Dark data hay còn gọi là dữ liệu tối, dữ liệu mà theo định nghĩa của Gartner – công ty tư vấn và nghiên cứu thị trường hàng đầu – là dữ liệu, nguồn thông tin mà một công ty, tổ chức thu thập, xử lý, lưu trữ thường xuyên trong quá trình hoạt động kinh doanh nhưng không tìm thấy mục đích sử dụng, không tìm thấy được giá trị của chúng. Một nghiên cứu từ các công ty nghiên cứu Exasol khảo sát các chuyên gia các công ty ở Anh và Đức, có 82% cho rằng họ không thể xác định dữ liệu nào là thực sự quan trọng. Và 55 % thừa nhận rằng sự phân tán dữ liệu trên nhiều hệ thống khác nhau cản trở nỗ lực của họ để tận dụng và khai thác tối đa giá trị từ dữ liệu.

Nguồn hình sdintelligence.info

Phân tích dữ liệu Big Data đòi hỏi các doanh nghiệp phải đầu tư vào các công cụ tiên tiến và nguồn nhân lực có chuyên môn cao, dĩ nhiên giá trị nhận được sẽ tương xứng nếu sự đầu tư là hợp lý và đúng đắn bao gồm cả các giải pháp dành cho những rủi ro liên quan đến Dark data, và vấn đề bảo mật thông tin, quyền riêng tư của người dùng. Với sự phát triển của các công cụ, phần mềm hỗ trợ khai thác Big data cho phép các cơ sở dữ liệu được liên kết, và lưu trữ trên hạ tầng đám mây tránh nguy cơ mất dữ liệu, kiểm soát dữ liệu trong cùng 1 hệ thống phục vụ để thực hiện việc phân tích, và bảo mật dữ liệu tuyệt đối. Mặc dù đây có thể được xem là giải pháp tạm thời, nhưng để hạn chế khối lượng Dark data thì mỗi công ty phải xác định chính xác mục đích của mỗi loại dữ liệu mà mình thu thập, hay phải áp dụng các thuật toán, model phân tích chính xác để khai phá giá trị của dữ liệu. Nếu dữ liệu thu thập đến sau cùng không đem lại kết quả, thì đây chính là thất bại của toàn bộ dự án Big Data.

- Các nhà quản lý đứng đầu bộ phận dữ liệu (Chief Data Officer) sẽ có vai trò lớn hơn

Big Data hay Data Analytics đang trở thành những hoạt động không thể thiếu trong mỗi công ty, tổ chức, đóng góp trực tiếp vào các chiến lược kinh doanh trong tương lai, vai trò của người đứng đầu bộ phận dữ liệu sẽ lớn hơn và phức tạp hơn. Không như trước đây, người đứng đầu hay nhân viên trong bộ phận dữ liệu chỉ có nhiệm vụ xử lý, phân tích dữ liệu, dựa vào kết quả viết các báo cáo gửi lên các giám đốc, quản lý cấp cao trong ban điều hành. Hiện nay hay trong tương lai tới, người đứng đầu bộ phận dữ liệu sẽ cần tham gia hơn nữa vào các nhiệm vụ phức tạp liên quan đến định hướng phát triển, tầm nhìn chiến lược của công ty, đề xuất các giải pháp khắc phục vấn đề bên trong và bên ngoài công ty,.. Đây cũng được xem là cơ hội phát triển nghề nghiệp dành cho những người làm về dữ liệu.

- Quantum Computing (Điện toán lượng tử)

Điện toán lượng tử được xem là bước tiến lớn tiếp theo của Big Data và Data Analytics. Máy tính lượng tử sử dụng Qubit hay còn gọi là Bit lượng tử. Khác với máy tính thông thường dữ liệu mã hóa thành các chữ số nhị phân, mỗi số được gán 1 trong 2 trạng thái nhất định là 0 hoặc 1, Quantum Computing sử dụng các bit lượng tử ở trong trạng thái chồng chập để tính toán có nghĩa là 1 bit lượng tử có thể có giá trị 0 và 1 ở cùng 1 thời điểm do đó có thể lưu trữ khối lượng lớn dữ liệu, có thể xử lý dữ liệu bằng các thuật toán phức tạp hơn, nhanh hơn.

Dịch vụ Quantum Computing của D-wave (Nguồn Iottechonologies.com)

Với các công nghệ hiện tại, việc phân tích và xử lý các bộ dữ liệu lớn vẫn gặp khó khăn, nhiều thách thức khác về thời gian, tốc độ. Thông qua Quantum Computing, các nhà quản lý, chuyên gia có thể giảm thời gian xử lý dữ liệu, qua đó có thể đưa ra quyết định, giải pháp kịp thời. Những gã khổng lồ về công nghệ như Google và IBM đang trong quá trình nghiên cứu và xây dựng máy tính lượng tử đầu tiên trên thế giới (công ty phần mềm điện toán lượng tử đầu tiên trên thế giới trụ sở Canada có tên 1QB). Thông qua điện toán lượng tử, việc mã hóa dữ liệu, hỗ trợ các giải pháp trong thời gian thực và giải quyết vấn đề phức tạp có thể được thực hiện một cách hiệu quả. Mặc dù đang ở giai đoạn đầu nghiên cứu, điện toán lượng tử đã được ứng dụng trong nhiều ngành khác nhau. Không lâu nữa, Google, IBM và Microsoft sẽ bắt đầu thử nghiệm máy tính lượng tử để tích hợp chúng vào quy trình kinh doanh của họ.

- Edge computing (Điện toán ranh giới)

Điện toán ranh giới là phương pháp tối ưu hóa hệ thống điện toán đám mây hay còn gọi Cloud Computing thông qua việc thu thập, xử lý, phân tích dữ liệu tại vùng “biên” của mạng, nơi gần nguồn dữ liệu nhất. Các máy chủ sẽ được đặt gần nơi thu thập dữ liệu, xử lý dữ liệu cục bộ trước sau đó mới truyền tải dữ liệu lên hệ thống máy chủ trên Cloud. Edge Computing được ứng dụng ở rất nhiều lĩnh vực, đặc biệt phổ biến đối với các thiết bị IoT, các thiết bị thông minh có kết nối Internet. Ví dụ các thiết bị cảm biến cập nhật dữ liệu liên tục theo thời gian và không thể chuyển hết tất cả dữ liệu lên Cloud mà phải xử lý trước, tức các thiết bị cảm biến sẽ tính toán, chọn lọc dữ liệu, phân tích, “format” lại rồi mới truyền tải lên Cloud. Edge Computing cung cấp các ưu điểm về tốc độ, bảo mật, giảm thiểu khối lượng dữ liệu phải lưu trữ ở Cloud qua đó giảm chi phí.

Sự phát triển mạnh mẽ của IoT, kéo theo sự phổ biến rộng rãi của Edge Computing trong những năm sắp tới, không chỉ 2019. Edge Computing mang lại nhiều lợi ích trong việc khai thác Big Data. Nhiều công ty đang chuyển sang đầu tư vào các thiết bị được kết nối để thu thập thêm dữ liệu về khách hàng hoặc quy trình kinh doanh. Điều này đã tạo ra nhu cầu đổi mới công nghệ nhằm tăng tốc độ cho việc thu thập, truyền tải dữ liệu vào đám mây, phân tích và xử lý, giúp các công ty phản ứng nhanh với các tình huống, sự cố bất ngờ. Edge Computing mang lại năng suất tốt hơn và các công ty cũng có thể hưởng lợi từ chi phí lưu trữ và cơ sở hạ tầng nếu các dữ liệu không cần thiết được thu thập từ IoT bị loại bỏ.

Nguồn: lanner-america.com

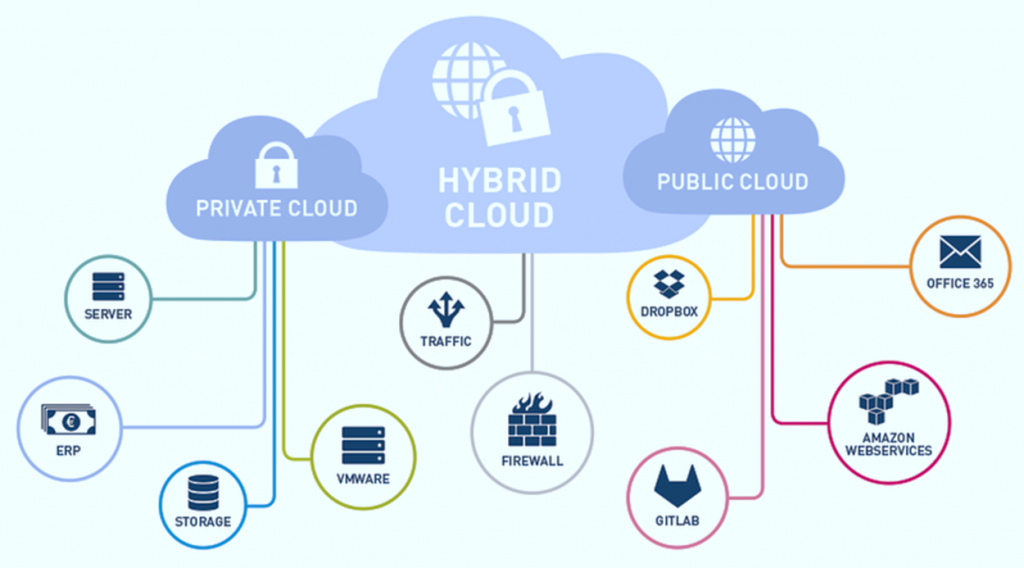

- Sự phát triển của xu hướng Hybrid Cloud

Hybrid Cloud là một môi trường, hệ thống điện toán đám mây kết hợp cả 2: nền tảng lưu trữ đám mây riêng – private cloud của riêng một tổ chức, và các dịch vụ lưu trữ đám mây như của Google, Amazon hay còn gọi là public cloud. Sự linh hoạt và các lợi ích của Hybrid Cloud có thể giúp các công ty giải quyết các vấn đề về bảo mật, vấn đề lưu trữ khối lượng lớn dữ liệu, vấn đề di chuyển các ứng dụng từ private cloud đến public cloud và ngược lại. Ví dụ, Public Cloud có thể được sử dụng cho các dự án có khối lượng lớn dữ liệu, tính yêu cầu bảo mật thấp, chẳng hạn như các poster, banner quảng cáo qua email và Private Cloud có thể được sử dụng cho các dữ liệu nhạy cảm hơn, chẳng hạn như báo cáo tài chính. Dự báo trong năm 2019, khi nhu cầu thu thập dữ liệu Big Data gia tăng thì xu hướng Hybrid Cloud sẽ phổ biến hơn.

Nguồn cloudoye.com

- Hệ thống an ninh mạng sẽ được đầu tư nhiều hơn, chặt chẽ hơn

Nhiều công ty, tổ chức trong những năm vừa qua luôn trong trạng thái lo sợ từ những vụ xâm nhập, đánh cắp dữ liệu, “hack” hệ thống bởi bọn tội phạm, tin tặc, hackers. Điều này tạo nên làn sóng, và nhu cầu bảo mật dữ liệu, thông tin cực kỳ mạnh mẽ. Việc phát triển và ứng dụng các thiết bị IoT cũng khiến vấn đề bảo mật trở nên đau đầu hơn. Để giải quyết mối đe dọa liên tục này, các công ty về Big Data tham gia để giúp các tổ chức sử dụng phân tích dữ liệu như một công cụ để dự đoán và phát hiện các mối đe dọa an ninh mạng. Các dự án Big Data có thể được tích hợp vào chiến lược an ninh mạng thông qua dữ liệu lịch sử, nhật ký bảo mật, có thể được sử dụng để cung cấp thông tin về các mối đe dọa trong quá khứ. Điều này có thể giúp các công ty ngăn chặn và giảm thiểu tác động của các vụ hack và đánh cắp dữ liệu trong tương lai.

- Các giải pháp “nguồn mở” sẽ tiếp tục phát triển mạnh

Open-source hay còn gọi nguồn mở là các công nghệ, công cụ, phần mềm cho phép các máy tính, hệ thống kết nối với nhau để giải quyết các vấn đề về khối lượng dữ liệu, xử lý, phân tán dữ liệu, được ứng dụng chủ yếu trong lĩnh vực Big Data. Các công cụ Open-source như là trung tâm của một hệ sinh thái đang phát triển của các công nghệ Big Data, hỗ trợ Predictive Analytics, Data Mining, và Machine Learning.

Trong nửa cuối năm 2018 xu hướng ứng dụng các công cụ nguồn mở đã bắt đầu trổi dậy và dự báo trong năm 2019 sẽ phát triển hơn nữa. Phần mềm và các công cụ dữ liệu nguồn mở sẽ có sẵn trên đám mây. Nhiều công cụ khác như Hadoop, Elaticsearch và Cassandra sẽ ra mắt. Những công cụ này sẽ được nâng cấp so với những phiên bản hiện tại, tốc độ nhanh hơn, cho phép truy cập, xử lý dữ liệu trong thời gian thực với chi phí phù hợp để các doanh nghiệp vừa và nhỏ sẽ có cơ hội tiếp cận với Big Data nhiều hơn.

- Sự xuất hiện của các Chatbot thông minh hơn

Chatbot là hệ thống máy tính, phần mềm trả lời, tương tác một cách trực tiếp với con người một cách tự động.

Chúng tôi cũng đã cung cấp một số bài viết về Chatbot trên website nên sẽ không nói chi tiết trong bài viết này, mời các bạn tham khảo qua các link dưới đây:

Khái niệm: https://bigdatauni.com/vi/tin-tuc/tong-quan-ve-chatbot-phan-1-chatbot-la-gi.html .

Cách thức hoạt động Chatbot: https://bigdatauni.com/vi/tin-tuc/tong-quan-ve-chatbot-phan-2-chatbot-hoat-dong-nhu-the-nao.html

Lợi ích Chatbot: https://bigdatauni.com/vi/tin-tuc/tong-quan-ve-chatbot-phan-3-loi-ich-cua-chatbot.html

Nhờ vào công nghệ AI đang được đầu tư mạnh bởi các tập đòan công nghệ hàng đầu, các Chatbot ngày nay hiện đang được ứng dụng trong kình doanh, được triển khai để xử lý các truy vấn của khách hàng nhằm cung cấp các tương tác cá nhân hóa hơn đồng thời loại bỏ nhu cầu nhân sự thực tế về mặt con người. Big Data cũng đóng vai trò cực kỳ quan trọng đối với Chatbot, bằng cách hỗ trợ thu thập, xử lý dữ liệu khách hàng, phân tích hành vi, dự đoán nhu cầu khách hàng để giúp Chatbot cung cấp các câu trả lời, tương tác chính xác nhất, nhanh nhất, tăng tối đa trải nghiệm của khách hàng. Thông qua các cuộc đối thoại, hệ thống sẽ thu thập và phân tích thông tin về khách hàng từ các cuộc trò chuyện. Quá trình này có thể giúp các nhà marketing phát triển các chiến lược hợp lý hơn để gia tăng doanh số.

- Data Curator (Nhân viên giám sát dữ liệu)

Năm 2019, nhiều tổ chức, công ty sẽ thêm vị trí nhân viên giám sát dữ liệu (Data Curator) trong các bộ phận dữ liệu. Vai trò của Data Curator sẽ bao gồm trách nhiệm quản lý dữ liệu cho các giai đoạn, nhiệm vụ phân tích khác nhau, phân bổ nguồn lực hợp lý để tăng tốc quá trình phân tích, giải thích, mô tả dữ liệu (trong metadata và data catalog), tổ chức các project cho nhóm Data Analyst, và Data Engineer để hợp tác làm việc hiệu quả hơn. Data Curator không chỉ quản lý và duy trì dữ liệu mà còn có thể tham gia vào việc xác định các giải pháp khai thác dữ liệu.

Ngoài ra, Data Curator cũng thường phụ trách các báo cáo, với dữ liệu được hiển thị trực quan dưới dạng biểu đồ, đồ thị hoặc trình chiếu. Data Curator là trung gian, đứng giữa Data Engineer (kiến trúc sư dữ liệu phụ trách việc chuyển đổi, lưu trữ, luân chuyển, dữ liệu qua các hệ thống được xây dựng trước đó và bằng các ngôn ngữ lập trình, mã hóa) và Data Scientist/Data Analyst (phụ trách phân tích, trả lời những thắc mắc, câu hỏi truy vấn dữ liệu bằng các model, thuật toán phân tích). Data Curator cũng cần có kỹ năng giao tiếp tốt ngoài các kỹ năng, kiến thức chuyên môn, đặc biệt hiểu ý nghĩa của dữ liệu cũng như các công nghệ được áp dụng để khai thác dữ liệu.

Tomer Shiran, đồng sáng lập và CEO của Dremio, cho biết: “ Data Curator chịu trách nhiệm tìm hiểu các công cụ phân tích, các bước, nhiệm vụ khai thác dữ liệu sẽ được thực hiện bởi những bộ phận nào trong tổ chức; xác định dữ liệu nào phù hợp và cần xử lý; phụ trách các bước liên quan đến chuyển đổi dữ liệu thô hỗ trợ Data Analysts. Data Curator hỗ trợ Data Analyst đẩy nhanh quá trình tiếp cận từ đầu đến cuối các dữ liệu quan trọng”

- Bộ luật GDPR (General Data Protection Regulation)

Liên minh châu Âu EU đã thi hành bộ luật bảo vệ dữ liệu chung GDPR vào 25/5/2018, mặc dù mới áp dụng để bảo vệ dữ liệu và quyền riêng tư của công dân EU, nhưng dự báo sẽ tác động đến các quốc gia trên toàn thế giới, đặc biệt khi vấn đề sử dụng, lạm dụng thông tin, dữ liệu cá nhân của các tập đoàn, công ty công nghệ nổi tiếng đang rất phức tạp, nghiêm trọng. Hơn nữa từ khi Big Data, AI, Machine Learning phát triển mạnh cùng với việc hầu hết người dân các nước đều đang sử dụng các ứng dụng thông minh, trang mạng xã hội,.. các công ty lớn dễ dàng thu thập dữ liệu người dùng hơn, do đó cần các bộ luật để bảo vệ thông tin người dùng.

Mặc khác đây cũng là thách thức lớn của các dự án Big Data, thách thức xây dựng một hệ thống bảo mật cực kỳ chặt chẽ và an toàn. Một số tổ chức đa quốc gia đang nỗ lực thúc đẩy các quan hệ khách hàng bằng cách tuyên bố họ sẽ cung cấp các biện pháp bảo vệ quyền riêng tư giống nhau cho tất cả khách hàng của họ, bất kể họ sống ở đâu, ở đất nước nào. Một số công ty lớn khác lại tập trung đầu tư vào công nghệ, xây dựng hạ tầng thông tin mục đích thu thập nhiều hơn nữa dữ liệu của người dùng và tăng độ bảo mật cao.

Trong năm 2019, chính phủ Hoa Kỳ có thể nỗ lực cho ban hành và áp dụng các bộ luật tương tự GDPR và buộc các công ty chịu trách nhiệm về cách họ bảo vệ quyền riêng tư và dữ liệu cá nhân khách hàng.

Về chúng tôi, công ty BigDataUni với chuyên môn và kinh nghiệm lâu năm trong lĩnh vực Big Data sẵn sàng hỗ trợ các công ty đối tác trong việc xây dựng và quản lý hệ thống dữ liệu một cách hợp lý, tối ưu nhất để hỗ trợ cho việc phân tích và đưa ra các giải pháp. Các dịch vụ của chúng tôi bao gồm “Tư vấn và xây dựng hệ thống dữ liệu Big Data”, “Khai thác dữ liệu Big Data dựa trên các mô hình thuật toán”, “Xây dựng các chiến lược phát triển thị trường, chiến lược cạnh tranh”.

Nếu các bạn có thắc mắc, hoặc có nhu cầu tư vấn hãy đừng ngần lại liên hệ với BigDataUni thông qua số điện thoại hoặc đăng ký thông tin ở mục “Liên hệ” để được chúng tôi tư vấn, hỗ trợ sớm nhất.

English

English